Anthropic gaat chats gebruiken om Claude te trainen

De beschuldigingen van auteursrechtschending en het gebruik van Claude als cyberwapen waren niet genoeg. Nu is er nog een onderwerp dat ongetwijfeld tot lange discussies zal leiden. Vanaf 28 september zal Anthropic chats en codeersessies gebruiken om AI-modellen te trainen en te verbeteren. Gebruikers kunnen deze instelling op elk moment wijzigen.

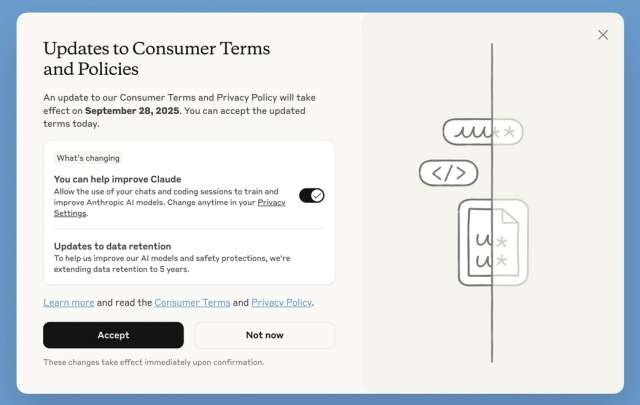

Let op de privacyverklaringAnthropic legt uit dat alle Large Language Models (LLM's) worden getraind met enorme hoeveelheden data. De data die wordt verkregen uit realtime interacties met chatbots is het meest bruikbaar. Vanaf vandaag zien gebruikers bij het inloggen een melding over het nieuwe privacybeleid. Het scherm bevat de optie ( al geselecteerd ) waarmee de Californische startup chattekst en codeersessies kan gebruiken om Claude-modellen te trainen en te verbeteren.

Zoals u op de schermafbeelding kunt zien, is de knop 'Accepteren ' gemarkeerd, maar u kunt ook op de knop 'Niet nu' klikken om uw beslissing uit te stellen. Gebruikers moeten uiterlijk 28 september een beslissing nemen, anders kunnen ze de dienst niet meer gebruiken.

De instelling is van toepassing op nieuwe en herstelde chats, evenals op codeersessies. Nieuwe gebruikers moeten tijdens het aanmeldingsproces een keuze maken. Deze wijziging is van toepassing op de Claude Free-, Pro- en Max- abonnementen (commerciële abonnementen, API-toegang, Amazon Bedrock en Google Vertex AI worden niet beïnvloed).

U kunt deze optie op elk moment uitschakelen in uw privacyinstellingen, maar deze optie is alleen van toepassing op toekomstige chats en codeersessies. Anthropic bewaart uw gegevens nog 30 dagen als u zich afmeldt. Als u zich aanmeldt om AI-modellen te trainen, worden uw gegevens vijf jaar bewaard.

Het bedrijf uit San Francisco garandeert dat gevoelige gegevens worden verduisterd of gefilterd via geautomatiseerde systemen en dat het de gegevens niet aan derden zal verkopen.

Punto Informatico